segunda-feira, 28 de julho de 2008

quinta-feira, 10 de julho de 2008

Você sabe quantas Calorias tem cada Alimento?

terça-feira, 8 de julho de 2008

Se você pensa que sabe tudo do Word antes leia essa Apostila.

O WORD, conhecido também como OFFICE, criado pela Empresa Microsoft, é uma poderosa ferramenta utilizada para edição de textos, ao alcance de sua criatividade.

Através dos vários comandos/ferramentas (formatação, visualização, correções ortográficas e gramaticais, inclusão de tabelas, cliparts, impressão, etc...), o programa WORD permite a criação de documentos, cartazes, cartões, formulários, desenhos, dentre outros

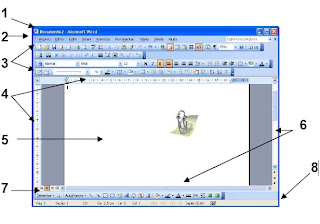

Microsoft Office Word 2003

1. Barra de Titulos

2. Barra de Menus

3. Barra de Ferramentas

4. Regua

5. Área de Escrita

6. Barra de Rolamento (Deslocamento)

7. Barra de Ferramenta Desenho

8. Barra de Status

Você quer saber mais clique no endereço abaixo e baixe toda a apostila para facilitar a sua vida.

segunda-feira, 7 de julho de 2008

Os limites físicos da computação

A lei de Moore ― todos nós a conhecemos (ou ao menos pensamos que sim). Para ser bem exato, a lei de Moore prevê que o número de componentes por circuito integrado (a um custo mínimo por componente) dobra a cada 24 meses (a previsão original, de 1965, era de 12 meses, mas a lei foi revisada). Pondo de maneira mais prática, a lei de Moore costuma ser usada para descrever o contínuo e exponencial crescimento da tecnologia da computação em diferentes áreas ― capacidade de discos, velocidade do clock e memória RAM, por exemplo. Sempre que nos aproximamos do limite de uma tecnologia de produção, surge o mesmo debate: será o fim da lei de Moore? Até agora, a resposta tem sido não.Mas a lei de Moore é, na verdade, uma afirmação da engenhosidade humana, das forças do mercado e da física. Sempre que o crescimento exponencial é impossibilitado em alguma área ― seja na velocidade do clock ou em uma determinada técnica de mascaramento ― os engenheiros descobrem uma nova área ou técnica que pode crescer exponencialmente. Nenhuma técnica mantém o crescimento exponencial por muito tempo, e a migração para novas técnicas é rápida o suficiente para que a taxa de crescimento continue a ser exponencial.A descoberta e o aperfeiçoamento das técnicas de produção é guiada de um lado pela demanda computacional, e do outro pela física. No meio há um terreno pantanoso feito de política, ciência e da boa e velha engenharia. É difícil compreender o vasto número de forças que orientam a demanda e os muitos fatores que afetam a inovação, incluindo a economia de escala, as atitudes culturais diante de novas idéias, as amplas campanhas de marketing e os estranhos eventos que ocorrem nos últimos suspiros das megacorporações. Fazendo uma comparação, é fácil compreender os limites da computação, desde que você tenha um bom entendimento de física quântica, teoria da informação e das propriedades dos buracos negros.

O "Laptop Supremo"No artigo Os Limites Físicos Supremos da Computação, publicado na revista Nature em 2000 e disponível em PDF aqui, o Dr. Seth Lloyd calcula (e explica) os limites da computação com base no conhecimentos atuais da física. Claro que ainda não conhecemos todos os aspectos da física - e estamos bem longe disso - mas como ocorre em outras áreas da engenharia, sabemos o suficiente para fazer algumas previsões extremamente interessantes sobre o futuro da computação. Esse artigo faz uso de trabalho já existente sobre os limites físicos da computação e introduz vários resultados curiosos, como o limite supremo da velocidade computacional. O que me parece mais interessante é um cálculo surpreendentemente específico de por quantos anos a lei de Moore continuará a ter efeito (continue lendo para saber!).O Dr. Lloyd começa assumindo que não temos a menor idéia de como será a tecnologia de fabricação de computadores no futuro. Muitas das discussões acerca da lei de Moore se baseiam nos limites físicos de técnicas de fabricação específicas, como o limite do tamanho de recursos em máscaras ópticas imposto pelo comprimento de onda da luz. Ao invés disso, ele ignora completamente as técnicas de fabricação e usa várias constantes físicas importantes: a velocidade da luz c, a constante reduzida de Planck h, geralmente escrita com um traço sobre o h, símbolo não disponível em HTML, então você vai ter que imaginar), a constante gravitacional g e a constante de Boltzmann kB. Essas constantes e nosso conhecimento limitado da relatividade geral e da física quântica são suficiente para deduzir muitos limites importantes da computação. Por isso, estes resultados não dependem de nenhuma técnica de fabricação em particular.O artigo usa o artifício do "Laptop Supremo" para tornar os cálculos mais concretos. O laptop supremo tem massa de um quilo e volume de um litro (por coincidência, quase o mesmo do Eee PC em 2008), e opera nos limites físicos máximos da computação. Aplicar os limites ao laptop supremo ajuda a entender o tipo de poder computacional portátil que se pode obter - sem considerar a vida útil da bateria, é claro.

A energia limita a velocidadeEntão, quais são os limites? O artigo começa deduzindo o limite supremo do número de computações por segundo. Isso depende da energia total do sistema, E, que pode ser calculada com a famosa equação de Einstein que relaciona massa e energia, E = mc2 (eu avisei que íamos precisar da velocidade da luz). Dada a energia total do sistema, precisamos saber o quão rápido o sistema poderá mudar de um estado distinguível para outro - por exemplo, para inverter bits. Isso é limitado pelo princípio da incerteza de Heisenberg. Lloyd diz o seguinte sobre o princípio da incerteza de Heisenberg:

Em particular, a correta interpretação do princípio da incerteza de tempo-energia de Heisenberg ΔEΔt ≥ h não é a de que é preciso tempo Δt para medir a energia com precisão ΔE (uma falácia que foi jogada para escanteio por Aharonov e Bohm), mas sim a de que um estado quântico com difusão em energia ΔE leva um tempo de no mínimo Δt = πh/2ΔE para evoluir para um estado ortogonal (e distinguível). Recentemente, Margolus e Levitin expandiram esse resultado para demonstrar que um sistema quântico com energia média E leva um tempo de no mínimo Δt = πh/2E para evoluir para um estado ortogonal.Em outras palavras, o princípio da incerteza de Heisenberg implica em dizer que um sistema levará uma quantidade mínima de tempo para mudar de maneira observável, e que o tempo está relacionado à energia total do sistema. O resultado é que um sistema de energia E pode realizar 2E/πh operações lógicas por segundo (uma operação lógica seria, por exemplo, realizar a operação AND em dois bits de entrada - pense nisso mais ou menos como operações de bit único). Como o laptop supremo tem massa de um quilo, ele tem energia E = mc2 = 8.9874 x 1016 joules. O laptop supremo pode realizar um máximo de 5.4258 x 1050 operações por segundo.O quão perto estamos das 5 x 1050 operações por segundo de hoje? Cada operação dessas é basicamente uma operação de bit único, então devemos converter as medidas atuais de desempenho a suas operações de bit único por segundo equivalentes. A medida mais comum disponível para operações por segundo é a FLOPS (operações de ponto flutuante por segundo) medida pela LINPACK (consulte a página da Wikipedia sobre FLOPS). Estimar o número exato de operações físicas de bit único envolvidas em uma operação de ponto flutuante de 32 bits exigiria conhecimento proprietário da implementação FPU. O número de FLOPS relatados pela LINPACK varia bastante dependendo do nível de otimização do compilador. Neste artigo, faremos uma estimativa bem genérica de 1000 operações de bit único por segundo (SBOPS) por FLOPS, e pedimos a qualquer um com uma estimativa melhor que a poste nos comentários.Com nosso fator de conversão de 1000 de FLOPS para SBOPS, o dono do recorde atual da LINPACK, o supercomputador Roadrunner (que está perto da minha cidade natal, Albuquerque, no Novo México) alcança a velocidade de 1 petaflop, ou 1000 x 1015 = 1 x 1018 SBOPS. Mas isso num supercomputador ― estamos falando do laptop supremo, que só tem um quilo de massa e um litro de volume. As CPUs de laptops estão por volta de um gigaflop, ou 1012 SBOPS, nos deixando a 39 ordens de magnitude de atingir o limite físico teórico de velocidade computacional. Por fim, os computadores quânticos existente já alcançaram o limite supremo de velocidade computacional ― em um pequeno número de bits, e em ambientes de pesquisa, mas que alcançaram, alcançaram.

A entropia limita a memória.O que nós queremos mesmo saber do laptop supremo é quantos DVDs adquiridos legalmente poderemos armazenar nele. A quantidade de dados que um sistema pode armazenar é uma função do número de estados físicos distinguíveis que ele pode suportar ― cada configuração distinta de memória exige um estado físico distinto. De acordo com Lloyd, "sabemos há mais de um século que o número de estados acessíveis de um sistema físico, W, está relacionado a sua entropia termodinâmica pela fórmula: S = kB ln W" (S é a entropia termodinâmica do sistema). Isso significa que podemos calcular o número de bits que o laptop supremo pode armazenar se soubermos sua entropia total.Calcular a entropia exata de um sistema é bem difícil. Do artigo:

Para calcular a entropia máxima de um quilo de matéria em um volume de um litro precisamos de um completo conhecimento das dinâmicas de partículas elementares, gravidade quântica etc. Não possuímos esse conhecimento. Entretanto, a entropia máxima pode ser estimada prontamente com um método que lembra o usado para calcular quantidades termodinâmicas do início do universo. A idéia é simples: modelar o volume ocupado pelo computador como uma coleção de modos de partículas elementares com energia média total E.A discussão que se segue é da pesada; por exemplo, inclui uma observação de que o número de baryon pode não ser conservado no caso de computação em buraco negro, e nesse ponto eu vou ter que confiar na palavra do Dr. Lloyd. Mas o resultado é que o laptop supremo, operando com máxima entropia, poderia armazenar ao menos 2.13 x 1031 bits. Claro que o máximo de entropia significa que toda a matéria do laptop seria convertida em energia ― o que é, basicamente, o equivalente a uma explosão termonuclear. Como observa Lloyd, "é claro que criar uma embalagem para isso já torna pouco provável que possamos alcançar esse limite." Talvez num próximo artigo possamos discutir a Embalagem de Laptop Suprema...E o quão próximos os computadores modernos estão desse limite? Um laptop moderno de 2008 pode armazenar até 250GB ― em torno de 2 x 1012 bits. Estamos umas 19 ordens de magnitude distantes da capacidade máxima de armazenamento, ou mais umas 64 duplicações na capacidade. A capacidade do disco, medida em bits por polegada quadrada, dobrou 30 vezes entre 1956 e 2005, e nesse ritmo, isso vai se repetir mais 64 vezes num período entre 50 e 100 anos. Não é o limite total da lei de Moore aplicado à computação, mas sugere a possibilidade de um fim para a lei de Moore no que se refere ao armazenamento em nosso tempo de vida. Acho que nós, desenvolvedores de sistemas de arquivos, deveríamos começar a pensar num segundo emprego...

Redundância e correção de errosOs computadores atuais não se aproximam dos limites físicos da computação por muitos motivos. Como Lloyd observa, "Boa parte da energia [dos computadores atuais] está retida na massa de partículas das quais o computador é construído, deixando apenas uma fração infinitesimal para a realização de lógica." O armazenamento de um único bit na DRAM usa "bilhões e bilhões de graus de liberdade" ― elétrons, por exemplo ― ao invés de apenas um grau de liberdade. Os computadores atuais tendem a conduzir computações a temperaturas em que a matéria permaneça na forma de átomos, e não de plasma.Outro limite prático fascinante da computação é a taxa de erros de operações, que está atada à taxa em que o computador por dispersar calor no ambiente. O fato é que operações lógicas, por natureza, não exigem a dissipação de energia, como originalmente teorizado por von Neumann. Operações reversíveis (como NOT) que não destroem informações não exigem a dissipação de energia; isso só ocorre em operações irreversíveis (como o AND). Intuitivamente, isso faz sentido; a única maneira de destruir um bit é transformar a informação em calor, do contrário o bit terá sido apenas movido para outro lugar e a informação representada por ele ainda estará por lá. A computação reversível foi implementada e demonstra uma dissipação de força extremamente baixa.É claro que alguma energia sempre será dispersada, mesmo que a computação seja reversível. No entanto, o apagamento de bits - e dos erros, em particular - exige um gasto mínimo de energia. A taxa na qual o sistema pode "despejar erros no ambiente" na forma de calor limita a taxa de erros de bits do sistema; ou, de forma semelhante, a taxa de erros de bits, combinada à taxa de transferência de calor para fora do sistema limita a taxa de operações com bits. Lloyd estima que a taxa na qual o sistema possa despejar erros no ambiente, relativa à área de superfície, e assumindo a radiação de um corpo escuro, seja de 7.195 x 1042 bits por metro2 por segundo.Limites computacionais da "poeira inteligente"Na mesma época em que li o artigo "Limites Supremos", também li Uma Profundidade no Céu de Vernor Vinge, um dos muitos livros de ficção-científica que retratam alguma forma de "poeira inteligente." A poeira inteligente é um conceito de elementos computacionais mínimos espalhados pelo ambiente e que operam como computadores distribuídos de baixa energia. A poeira inteligente do livro de Vinge tinha capacidade suficiente para um manual de sistemas completo, o que a mim pareceu uma quantidade de armazenamento absurdamente grande para algo do tamanho de um grão de areia. Por isso eu me sentei e calculei os limites computacionais e de armazenamento de um computador que medisse apenas 1 μm3 de tamanho, sob as limitações impostas por sua matéria na forma de átomos, e não de plasma.Lloyd calcula que, sob essas condições, o laptop supremo (de um quilo e um litro) pode armazenar em torno de 1025 bits e conduzir 1040 operações de bit único por segundo. O laptop supremo tem um litro, e há 1015 μm3 em um litro. Dividindo o armazenamento e as operações por segundo totais por 1015 nos leva a 1010 bits e 1025 operações por segundo - por volta de 1 gigabyte de armazenamento de dados e tantos FLOPS que os prefixos até perdem o sentido. Basicamente, o potencial computacional de uma poeira ultrapassa e muito o maior supercomputador do planeta - pirem, autores de ficção-científica! É claro que nenhum desses cálculos leva em conta a entrega de energia ou a largura de banda de entrada e saída, que pode acabar sendo bem mais importante aos limites da computação.

As implicações do laptop supremoCalcular os limites do laptop supremo foi muito divertido, mas o que isso significa para a ciência da computação hoje? Sabemos o suficiente para termos uma base teórica genérica de por quanto a Lei de Moore terá efeito. Os laptops atuais armazenam 1012 bits e conduzem 1012 operações de bit único por segundo. O laptop supremo pode armazenar 1031 bits e conduzir 1051 operações de bit único por segundo, abismos fatoriais de 1019 e de 1039 respectivamente. Pelas estimativas de Lloyd, presumindo que a densidade de armazenamento e a velocidade computacional irão crescer em um fator de 108 em 50 anos, o limite do armazenamento será alcançado em uns 125 anos e o de operações por segundo em 250 anos. Imagina-se que os últimos 125 anos sejam de uma busca frenética por melhores algoritmos de compressão - ou de pesquisas físicas teóricas avançadas.Quando a lei de Moore alcançar seu limite, a única maneira de aumentar o poder computacional será aumentar a massa e o volume do computador, e isso também acabará encontrando limites fundamentais. Um artigo não publicado intitulado Limites Universais da Computação estima que toda a capacidade computacional do universo se acabaria 600 anos antes da lei de Moore.Até lá, teremos 250 anos fascinantes. É um bocado de tempo para ser relevante a nós que estamos vivos hoje, mas não é tempo suficientemente pequeno para ser ignorado. Os horizontes típicos de planejamento para empreitadas humanas de longo termo (como as relacionadas ao ecossistema) costuma chegar no máximo a uns 300 anos, então talvez não seja tão impensável começar a fazer planos para o fim da lei de Moore. Eu vou começar a trabalhar no algoritmo de compressão LZVH amanhã mesmo.Uma coisa está clara: nós vivemos a Era de Ouro da computação. Vamos curtir ao máximo.

Você sabe o que é Overclock?

Conhecimento Básico de Informática.

A primeira coisa a ser ensinada nas escolas é o alfabeto. Pensando deste modo achei que a melhor coisa a fazer é começar ensinando uma noção básica sobre o computador em si, seus principais itens e funções. Vamos ao nosso primeiro tutorial.

1. Conceito de hardware e software

Hardware é tudo que faz parte fisicamente do seu computador, ou seja, são as peças que compõe ele.

Software são os programas que fazem seu computador funcionar e realizar tarefas como editar um texto, imprimir uma foto, enviar um email, etc.

Algumas pessoas dividem o software em duas categorias: utilitários em geral (programas para gravação de CDs, edição de imagens, textos, planilhas de cálculos, email, navegação na internet, etc) e sistemas operacionais.

Os sistemas operacionais são responsáveis por dar vida ao seu computador, digamos assim. É através de um sistema operacional que você pode usar o seu computador, ele é a sua principal forma de controlar a máquina. Sem um sistema operacional não existe função para um computador, ele não será mais do que um amontoado de hardware (ou peças) sem utilidade.

Mas então qual é o seu sistema operacional?? Isso depende do computador que você comprou ou vai comprar, os mais comuns são o Windows (pronuncia-se “uindous”), o Linux e o Macintosh (pronuncia-se “méque-in-tochi”).

A maioria esmagadora dos computadores em uso atualmente trabalha com o sistema operacional Windows.

2. Conhecendo o hardware um pouco melhor

O seu computador é o resultado da soma de peças que trabalham em conjunto para que seja possível fazer qualquer coisa nele. A capacidade de executar um software (programa) mais avançado é determinada pela capacidade do seu hardware (peças). Isso significa que uma máquina com hardware mais simples não terá um bom desempenho ao executar um programa mais sofisticado, como um editor de vídeos, por exemplo.

Vamos fazer uma breve introdução sobre o hardware, mostrando as principais peças.

Placa-Mãe: ela pode ser considerada o coração do computador, todas as peças do micro estão ligadas à ela. É ela quem determina qual o tipo de memória, HD, processador e outros itens que serão usados, e por isso mesmo é ela quem dita as possibilidades de melhoria da capacidade de hardware do computador no futuro. Boas placas-mãe suportam processadores mais simples e mais avançados (desde que sejam do mesmo padrão), aceitam uma boa quantidade de memória (em geral o máximo suportado varia entre 2GB e 4GB para micros caseiros) e possuem no mínimo 3 encaixes livres para adicionar placas extras (rede, som, captura de tv, etc). Abaixo temos um exemplo:

Quer saber mai

s sobre placas-mãe? Então visite: Infowester

s sobre placas-mãe? Então visite: Infowester Memória: Algumas pessoas fazem uma analogia errada sobre as memórias. Elas não guardam os seus arquivos (fotos, textos, músicas…). O responsável por armazenar seus arquivos é o HD. As memórias permitem que o seu computador trabalhe com as informações enquanto a máquina está ligada, de certo modo elas até armazenam informações e arquivos, mas de forma temporária, apenas enquanto você está trabalhando neles. Para que o processador trabalhe com um arquivo ou com um programa ele precisa da ajuda das memórias, por isso, quanto mais memória seu computador tiver melhor será o desempenho dele. Existem diversos tipos de memória no mercado, cada tipo serve em uma determinada placa-mãe e funciona junto com um determinado processador. O principal ponto que você deve saber é que a quantidade de memória influencia no desempenho do micro, portanto se for possível procure máquinas com a maior quantidade de memória que seu dinheiro puder pagar. Atualmente valores entre 1GB e 2GB de memória atendem a maioria dos usuários domésticos. Exemplo de uma memória:

órias? Então visite: Infowester

órias? Então visite: Infowester Processador: como um determinado fabricante gosta de dizer, este é o cérebro do seu computador. Tudo que acontece nele passa pelo processador e ele é o principal componente para determinar a velocidade da sua máquina. Quando mais rápido é o processador mais rápido será o uso do computador e melhor será a sua capacidade para rodar um jogo ou mais de um programa ao mesmo tempo. Aqui é importante que você tenha em mente que existem processadores de apenas um núcleo e processadores de mais de um núcleo. Esses processadores com 2 ou mais núcleos - também conhecidos com “dual core” e “quad core”- trabalham de forma mais eficiente, portanto, se você for escolher um micro dê preferência a máquinas que possuem esses processadores. Exemplo de um processador:

mais sobre processadores? Então visite: Infowester

mais sobre processadores? Então visite: Infowester HD ou disco rígido: esse é o responsável por armazenar tudo que existe de software e arquivos dentro do seu computador. A ordem principal aqui é tamanho, quanto maior for a capacidade do seu HD mais informações, programas, jogos, fotos, etc você poderá guardar no seu computador. Atualmente os HDs usam um padrão chamado “SATA” e possuem capacidades de armazenamento que variam de 80GB até 500GB. Para usuários domésticos algo em torno de 160GB ou 250GB está excelente. Problemas no seu HD em alguns casos ocasionam a perda das informações armazenadas no computador, é por isso que você ouve algumas pessoas falando em “backup”, ou seja, uma cópia dos seus arquivos importantes (textos, fotos, músicas, etc) para um outro local, como um CD por exemplo. Assim caso aconteça algum acidente com o seu HD basta trocá-lo, reinstalar os programas e copiar seus arquivos que estão no CD de backup para o seu HD novo.

Quer saber mais

sobre HD? Então visite: Infowester

sobre HD? Então visite: Infowester Placa de vídeo: responsável por enviar a imagem para o seu monitor. Podem ser de dois tipos: “offboard” - quando vem separada da placa-mãe; e “onboard” - quando a placa de vídeo vem embutida de fábrica na placa-mãe (a maioria dos micros vendidos atualmente usam placas de vídeo onboard). Aqui você deve dar atenção para alguns itens, são eles:

- placas de vídeo offboard tem melhor desempenho, portanto se o seu computador vai rodar jogos, editar imagens e vídeos ou se você gosta de assistir DVDs com qualidade essa é a melhor opção. Placas de vídeo offboard com 256MB ou 512MB atendem muito bem aos usuários de jogos.

- placas onboard barateiam o preço final do computador, mas não devem ser escolhidas para uso em micros que irão rodar jogos - elas tem baixo desempenho e ainda utilizam parte da memória do computador para funcionar, prejudicando a performance geral do computador. Escolha esse tipo de placa se a sua intenção for navegar na internet, editar textos e planilhas de cálculo, email, assistir a filmes (sem uma qualidade excelente) e afins.

Quer saber mais s

obre placas de vídeo? Então visite: Guia do Hardware

obre placas de vídeo? Então visite: Guia do Hardware Esses são os principais itens a serem observados no momento da compra de um computador, pois eles afetarão diretamente a produtividade do micro. Caso você esteja interessado em saber mais sobre outros itens de hardware recomendo que leia esse guia de hardware para iniciantes do Infowester.

Esse foi o meu primeiro artigo para a campanha contra o analfabetismo digital. Em breve publicarei um texto sobre os cabos que ficam atrás do seu computador, mostrando para que serve cada um deles e como você deve conectá-los para que tudo funcione corretamente. Na seqüência vou começar a falar sobre emails e segurança na internet. Fiquem de olho no blog!

domingo, 6 de julho de 2008

Conexão wan no packet tracer da Cisco.

Conexão wan no packet tracer da Cisco. - Diogenes mas um material para te ajudar nos seus estudos.

Conexão wan no packet tracer da Cisco. - Diogenes mas um material para te ajudar nos seus estudos.O pré-requisito para este tutorial é compreender relativamente bem o conceito de subnetting. Se você ainda tem dificuldades com subredes, este post não irá ajuda-lo muito, creio. Aconselho, neste caso, a buscar e ler o que já foi postado sobre o tópico “subredes” (http://blog.ccna.com.br/?s=subredes). Pode ser de grande ajuda.

Vamos supor agora que esta rede foi segmentada em 2 subredes distintas:

192.168.10.64 /26 e192.168.10.128 /26

OBS: Aqui foi aplicada a regra 2 ^ x - 2. Se eta regra não fosse aplicada, teríamos as subredes 192.168.10.0 /25 e 192.168.10.128 /25. Lembrando que o exame CCNA considera a regra 2 ^ x - 2 para o cálculo de subredes (a não ser quando EXPLICITAMENTE mencionado na questão).

Subrede: 192.168.10.128hosts: 129 à 190Broadcast: 191

Agora, suponha que você, tendo em mãos este pequeno plano de endereçamento, tenha uma rede com a seguinte topologia para endereçar:

Comecemos pelas 3 redes WAN. Observe que todas são do tipo ponto-a-ponto, ou seja, precisam de apenas 2 endereços de host (um para cada interface de cada um dos 2 routers). Por exemplo, a rede que interliga o router A com o router B necessita de apenas 2 endereços IP: um para cada router. Assim sendo, precisamos de 3 redes /30, que têm esta característica (entregam apenas 2 endereços de host por subrede).

Vamos usar a rede 64 para obter as 3 redes /30 que precisamos:

192.168.010.064255.255.255.192 ==> 11111111.1111111.11111111.11000000

Os “zeros” em vermelho mostram até que ponto temos de avançar na máscara /26 para obtermos as redes /30. Quantas redes /30 conseguiríamos? Resposta: 2 ^ 4 = 16. Notem que aqui não se aplica a regra do “-2″. Esta regra não é aplicada para cálculo de subredes VLSM.

192.168.10.64, 68, 72, 76. 80, 84, 88, 92, 96, 100, 104, 108, 112, 116, 120 e 124, todas com máscara /30.

Para o nosso exercício, vamos reservar as 3 primeiras: 192.168.10.64 /30, 192.168.10.68 /30 e 192.168.10.72 /30.

Notem que ainda temos 13 subredes /30 que não serão usadas. O que poderíamos ter feito, para evitar este desperdício, é dividir a subrede 192.168.10.64 /26 em 2 subredes /27 (192.168.10.64 /27 e 192.168.10.96 /27), e subdividir a primeira (192.168.10.64 /27) em 8 subredes /30. Desta forma, desperdiçaríamos um menor número de endereços e ainda teríamos uma subrede /27, com capacidade para endereçar até 30 hosts sobrando, para uso futuro. Mas para efeitos didáticos, o exemplo inicial é mais fácil de ser compreendido.

192.168.010.128255.255.255.192 ==> 11111111.1111111.11111111.11000000

2 ^ x - 2 >= 20, sendo que o resultado (x) é o número de “zeros” da direita para a esquerda que teremos que preservar.

11111111.1111111.11111111.11100000

192.168.010.160255.255.255.224 ==> 11111111.1111111.11111111.11100000

192.168.10.160 /28e192.168.10.176 /28

Conexão WAN A - B: 192.168.10.64 /30Conexão WAN A - C: 192.168.10.68 /30Conexão WAN C - B: 192.168.10.72 /30

Localidade ligada ao router C: 192.168.10.192.168.10.128 /27 (até 30 hosts)Localidade ligada ao router A: 192.168.10.192.168.10.160 /28 (até 14 hosts) Localidade ligada ao router B: 192.168.10.192.168.10.176 /28 (até 14 hosts)

Se aparecer “ip subnet-zero” em algum ponto da questão. Lembrem-se que para VLSM e CIDR, a regra do “-2″ para cálculo de subredes NUNCA se aplica.

Seria basicamente isso. Pode não parecer simples à princípio, mas com prática pega-se o jeito da coisa e tudo fica tão claro quanto o cálculo de subredes. Posso ter errado aqui! Então, se algum de vocês refizerem os cálculos e encontrarem algum erro, por favor, postem nos comments. Aliás, este é um excelente exercício. Procurem refazer os cálculos e compreender o que foi feito, e procurem por falhas. Qualquer dúvida, postem nos comments e respondo-as com prazer!

Seguindo este tutorial, mais adiante publicarei um tutorial sobre CIDR e sumarização de rotas, para então entrarmos em uma série de tutoriais mais avançados sobre EIGRP, OSPF e BGP.

Um abraço para todos!

Leia também:

sexta-feira, 4 de julho de 2008

Como você pode Detecta uma colisão.

O acesso de múltiplos dispositivos de rede é uma boa maneira de começarmos a explorar as limitações da Ethernet, mas existe outro cenário que ainda temos de analisar. Vamos criar uma analogia da mesa de jantar e imaginar que existe um silêncio momentâneo na conversação. Você e eu temos coisas a falar e ambos sentimos o "peso do silêncio". Para resolver isso, começamos a falar quase ao mesmo tempo. Na terminologia da Ethernet, ocorre uma colisão quando os dois tentam falar ao mesmo tempo.

Em nosso caso, podemos resolver a situação de maneira civilizada. Após a percepção de que estávamos falando ao mesmo tempo, um de nós pára de falar para escutar o outro. Os nós da Ethernet também escutam o meio enquanto transmitem, para ter certeza de que são a única estação transmissora naquele momento. Se as estações começam a ouvir sua própria transmissão de forma distorcida ou misturada com a de outra estação sabem que uma colisão aconteceu. Às vezes, um segmento de Ethernet é chamado de domínio de colisão porque duas estações no segmento não podem transmitir ao mesmo tempo sem causar uma colisão. Quando as estações detectam uma colisão, elas interrompem a transmissão, esperam durante um período aleatório e tentam transmitir novamente quando detectam silêncio no meio.

A pausa aleatória e a repetição do envio do sinal representam parte importante do protocolo. Se as duas estações colidem quando estão transmitindo, então ambas terão de transmitir novamente. Na próxima oportunidade de transmissão, as estações envolvidas na colisão anterior terão dados prontos para transmitir. Se elas transmitissem novamente na primeira oportunidade, colidiriam de novo. Por isso existe um tempo de espera aleatório. Assim, dificilmente as duas estações vão continuar colidindo por muito tempo.

Fonte da pesquisa e onde você pode encontrar mais detalhes sobre o assunto.

http://informatica.hsw.uol.com.br/ethernet8.htm

Colisão de Dominios

Espero que essa postagem te ajude com o conflito de dominio Diogenes.

Elementos das redes Ethernet/802.3

A arquitetura de LAN mais comum é a Ethernet. A Ethernet é usada para transportar dados entre dispositivos em uma rede, como computadores, impressoras e servidores de arquivo. Como mostrado na figura, todos os dispositivos estão conectados ao mesmo meio. Os meios Ethernet usam um método de broadcast de quadros de dados para transmitir e receber dados entre todos os nós nos meios compartilhados.

O desempenho de uma LAN Ethernet/802.3 de meios compartilhados pode ser negativamente afetado por vários fatores:

• A natureza da distribuição de broadcasts de quadros de dados das LANs Ethernet/802.3.

• Os métodos de acesso CSMA/CD (Carrier sense multiple access collision detect) que permitem que apenas uma estação transmita de cada vez.

• As aplicações multimídia que exigem maior largura de banda, como, por exemplo, vídeo e Internet, associadas à natureza de broadcast da Ethernet, podem criar congestionamento na rede.

• A latência normal à medida que os quadros trafegam pelos meios da camada 1 e pelos dispositivos de rede das camadas 1, 2 e 3 e o aumento da latência causada pela extensão das LANs Ethernet/802.3 devido à adição de repetidores.

• O aumento das distâncias das LANs Ethernet/802.3 devido ao uso de repetidores da camada 1.

A Ethernet usando o CSMA/CD e um meio compartilhado pode suportar taxas de transmissão de dados de até 100 Mbps. O CSMA/CD é um método de acesso que permite que apenas uma estação transmita de cada vez. O objetivo da Ethernet é fornecer a melhor prestação de serviços possível e permitir que todos os dispositivos no meio compartilhado transmitam igualmente. Como mostrado na figura , um dos problemas inerentes à tecnologia CSMA/CD são as colisões.

Ethernet half duplex

A Ethernet é uma tecnologia half duplex. Cada host Ethernet examina a rede para ver se dados estão sendo transmitidos antes de transmitir dados adicionais. Se a rede já estiver em uso, a transmissão sofrerá um atraso. Apesar do atraso na transmissão, dois ou mais hosts Ethernet poderão transmitir ao mesmo tempo, o que resultará em uma colisão. Quando uma colisão ocorrer, o host que detectar primeiro a colisão vai emitir um sinal de congestionamento. Ao escutar o sinal de congestionamento, cada host vai aguardar por um período de tempo aleatório antes de tentar transmitir. O algoritmo de suporte da placa de rede cria esse período de tempo aleatório. Quanto mais hosts forem adicionados à rede e começarem a transmitir, maior a probabilidade das colisões ocorrerem.

As LANs Ethernet ficam sobrecarregadas porque os usuários executam softwares que exigem muito da rede, como as aplicações cliente/servidor, que fazem com que os hosts transmitam com mais freqüência e por maiores períodos de tempo. O conector físico (por exemplo, a placa de rede) usado pelos dispositivos em uma LAN Ethernet fornece vários circuitos para que a comunicação entre os dispositivos poss

Segmentação de LAN

Uma rede pode ser dividida em unidades menores chamadas de segmentos. Cada segmento usa o método de acesso CSMA/CD e mantém o tráfego entre os usuários no segmento.

A figura mostra um exemplo de uma rede Ethernet segmentada. A rede completa tem 15 computadores (6 servidores de arquivos e 9 PCs). Quando segmentos forem usados em uma rede, menos usuários/dispositivos estarão compartilhando os mesmos 10 Mbps ao se comunicarem entre si no segmento. Cada segmento é o seu próprio domínio de colisão.

Ao dividir a rede em três segmentos, um gerente de rede poderá diminuir o congestionamento na rede em cada segmento. Ao transmitir dados em um segmento, os cinco dispositivos em cada segmento estarão compartilhando a largura de banda de 10 Mbps por segmento. Em uma LAN Ethernet segmentada, os dados passados entre os segmentos são transmitidos no backbone da rede usando uma bridge, um roteador ou um switch.

A comutação de LAN ameniza a escassez de largura de banda e os gargalos de rede, como os que ocorrem entre um grupo de PCs e um servidor de arquivos remoto. Um switch pode segmentar uma LAN em microssegmentos, que são segmentos únicos de host. Isso cria domínios sem colisão a partir de um domínio de colisão maior. Mesmo que o switch LAN elimine os domínios de colisão, todos os hosts conectados ao switch ainda estarão no mesmo domínio de broadcast. Logo, todos os nós conectados pelo switch LAN podem ver um broadcast a partir de apenas um nó.

A Ethernet comutada é baseada na Ethernet. Cada nó está diretamente conectado a uma de suas portas ou a um segmento conectado a uma das portas do switch. Isso cria uma conexão de largura de banda de 10 Mbps entre cada nó e cada segmento no switch. Um computador conectado diretamente a um switch Ethernet é o seu próprio domínio de colisão e acessa todos os 10 Mbps.

Uma LAN que usa uma topologia Ethernet com switches cria uma rede que funciona como se tivesse apenas dois nós, o nó de envio e o nó de recebimento. Esses dois nós compartilham uma largura de banda de 10 Mbps, significando que quase toda a largura de banda está disponível para a transmissão dos dados. Como a LAN Ethernet com comutação usa a largura de banda com tanta eficiência, pode fornecer mais throughput do que as LANs Ethernet conectadas por bridges ou hubs. Em uma implementação da Ethernet comutada, a largura de banda disponível pode chegar perto de 100%.

A comutação Ethernet aumenta a largura de banda disponível em uma rede criando segmentos de rede dedicados (ou conexões ponto-a-ponto) e conectando esses segmentos a uma rede virtual no switch. Esse circuito de rede virtual existe apenas quando dois nós precisarem se comunicar. Por isso é chamado de circuito virtual, porque existirá apenas quando for necessário e será estabelecido no switch.

Uma desvantagem dos switches é que eles são mais caros do que os hubs. No entanto, muitas empresas implementam devagar a tecnologia dos switches, conectando hubs a switches até que os hubs sejam substituídos.

Descrever as duas operações básicas de um switch

A comutação é uma tecnologia que diminui o congestionamento nas LANs Ethernet, Token Ring e FDDI, reduzindo o tráfego e aumentando a largura de banda. Os switches LAN são freqüentemente usados para substituir hubs compartilhados. Eles são projetados para trabalhar com infra-estruturas de cabos que já existam para que possam ser instalados sem afetar o tráfego existente na rede.

Atualmente, nas comunicações de dados, todos os equipamentos de comutação executam duas operações básicas:

• Comutação de quadros de dados - isso acontece quando um quadro chega a um meio de entrada e é transmitido para um meio de saída.

• Manutenção das operações de comutação - um switch cria e mantém tabelas de comutação.

O termo bridging se refere a uma tecnologia na qual um dispositivo conhecido como bridge conecta dois ou mais segmentos de LAN. Uma bridge transmite datagramas de um segmento aos destinos em outros segmentos. Quando uma bridge for ativada e começar a operar, ela examinará o endereço MAC dos datagramas de chegada e criará uma tabela de destinos conhecidos. Se a bridge souber que o destino de um datagrama está no mesmo segmento da sua origem, abandonará o datagrama porque não precisará transmiti-lo. Se a bridge souber que o destino está em outro segmento, transmitirá o datagrama apenas naquele segmento. Se ela não souber o segmento de destino, transmitirá o datagrama em todos os segmentos exceto no segmento de origem (uma técnica conhecida como flooding). A principal vantagem do bridging é limitar o tráfego em determinados segmentos da rede.

Bridges e switches conectam os segmentos LAN, usam uma tabela de endereços MAC para determinar o segmento para onde um datagrama precisa ser transmitido e reduzem o tráfego. Os switches são mais funcionais que as bridges nas redes atuais porque operam em velocidades muito mais altas e podem suportar novas funcionalidades, como as LANs virtuais (VLANs)

http://redes.g2w.org/viewtopic.php?t=90

quinta-feira, 3 de julho de 2008

Fique fera no Excel.

Formulas do Excel.

Aproveite agora e não espere as duvidas aparecer baixe esse apostila do Excel onde tem varias formulas para facilitar o seu dia a dia.

http://www.apostilando.com/download_final.php?cod=2970&autenticado=nao

quarta-feira, 2 de julho de 2008

Dicas de Manutenção do seu Windows XP

Há centenas de maneiras de personalizar seu computador após a configuração. Reunimos algumas dicas sobre a configuração e personalização para que você explorar e experimentar.

• Modifique o Boot.ini

Como usar uma entrada de linha de comando para modificar o boot.ini.

• Altere a pasta de Abertura Padrão no Windows Explorer

Dicas & Truques do Windows XP: Altere a pasta de abertura padrão do Windows Explorer.

• Use o Teclado Virtual

Abra o teclado virtual e crie um atalho para ele em sua área de trabalho.

• Mantenha os Seus Programas Favoritos Próximos do Topo do Menu Iniciar

Dica de Especialista do Windows XP: Mantenha seus programas favoritos próximos do topo do menu Iniciar.

• Altere a Imagem da Tela de Boas Vindas

Como alterar a imagem dos usuários na tela de Boas Vindas se o seu computador é membro de um grupo de trabalho ou então um computador autônomo.

• Crie Sua Própria Mensagem de Logon

Como modificar o registro para criar a mensagem que aparece no logon.

• Adicione Ferramentas Administrativas ao seu Menu Iniciar

Adicione Ferramentas Administrativas ao menu Iniciar para obter acesso rápido no Windows XP.

http://www.microsoft.com/brasil/windowsxp/using/setup/learnmore/tips/default.mspx

Dicas de Cálculou no Excel

É muito comum termos de colocar como resultado final de um cálculo, não o valor puro, mas sim uma resposta, composta por uma palavra ou sentença, condicionada ao resultado numérico obtido. A isso chamamos de Respostas Condicionais.

Um bom exemplo é o do controle de aprovação de uma classe de alunos. Se um aluno tirar média final maior a 6 ele estará APROVADO, em caso da média ficar entre 4 e 6 deverá ir para EXAME, enquanto que se tiver média inferior a 4 estará REPROVADO.

Vamos a planilha que nos servirá como exemplo, adapte-a para atender às suas necessidades:

A B C D E

1 NOME NOTA1 NOTA2 MÉDIA RESULTADO

2 Francisco 7 9 8,0 APROVADO

3 José 3 8 5,5 EXAME

4 Maria 7 4 5,5 EXAME

5 Carla 5 7 6,0 EXAME

6 Mota 4 3 3,5 REPROVADO

A nossa necessidade: colocar as expressões "Aprovado", "Exame" ou "Reprovado" na coluna E, de acordo com a média final do aluno (que se encontra na coluna D). Como fazer? Simples, siga os passos abaixo:

Coloque o cursor na célula E2 e digite a fórmula:

=SE(D2>6; "APROVADO"; SE(D2<4; "REPROVADO"; "EXAME" ));

Copie a fórmula por todas as demais células da coluna E, no exemplo até a linha 6;

Pronto, já podemos saber e/ou mostrar quem passou, quem não passou, ou mesmo quem vai ter fazer o EXAME FINAL, sem precisar prestar, muita, atenção aos números da coluna D.

--------------------------------------------------------------------------------

Bem, terminou! Não? ah, já sei, tem sempre alguém querendo ainda mais, para dar maior e melhor visibilidade aos resultados, mesmo que já estejam mais claros. O que seria agora? Por que não colocar as respostas diferenciadas em azul (para os aprovados), verde (para quem vai para os exames) e vermelho (para os não aprovados). Como fazer?.

A melhor solução é usar o recurso da FORMATAÇÃO CONDICIONAL exclusiva do Excel 97. Veja como montar essa planilha:

Entre na planilha e selecione toda a faixa de células que devam ser formatadas condicionalmente;

Selecione o menu Formatar * Formatação Condicional;

Ao se abrir a janela "Formatação Condicional" (fig. 1) altere a condição 1 para IGUAL A

e preencha o campo de resultado com a expressão ="REPROVADO";

Nessa mesma janela clique no botão FORMATAR;

Ao se abrir a janela "Formatar Células" (fig. 1) selecione as opções desejadas

no caso, pelo menos escolha a cor VERMELHA;

Pressione o botão "ADICIONAR>>";

Ao se abrir mais um grupo de formatação condicional repita os passos #3 à #5

só que desta vez defina expressão ="EXAME" e a cor VERDE;

Pressione o botão "ADICIONAR>>";

Ao se abrir mais um grupo de formatação condicional repita os passos #3 à #5

só que desta vez defina expressão ="APROVADO" e a cor AZUL;

Pronto, o resultado final deverá ficar parecido com a tabela abaixo:

A B C D E

1 NOME NOTA1 NOTA2 MÉDIA RESULTADO

2 Francisco 7 9 8,0 APROVADO

3 José 3 8 5,5 EXAME

4 Maria 7 4 5,5 EXAME

5 Carla 5 7 6,0 EXAME

6 Mota 4 3 3,5 REPROVADO

http://www.superdicas.com.br/excel/